För de av oss som använder VMWare ESXi så kommer uppdateringar med jämna mellanrum. Ibland små buggfixar men ibland större revisioner som ger bättre prestanda och mer funktioner.

Nu har en sådan uppdatering kommit i sommar. Vi brukar avvakta med större uppgraderingar tills dess att alla barnsjukdomar är åtgärdade.

Inatt utförde Adminor uppgradering av våra interna VMWare ESXi miljöer från av VMWare ESXi 4.0 till 4.1 .

Innan 4.1 kunde man använda VMWare host update utility för att göra uppdateringar , denna har nu fasats ur för att förbereda avveckling av produkten ”ESX” till förmån för ”ESXi”.

Nu får man istället använda host update manager i vCenter om man har den ”licensen” , ”esxupdate” eller min favorit ”vihostupdate” .

Förutsätter att du redan har ett konto på vmware.com och en separat ESXi server du kan köra vMA (vmware Management Assistant) appliance. Har du inte det kan du ladda ned konsol-verktygen till valfritt operativsystem här.

För att följa vår guide helt och hållet behöver du även en webbserver du kan ladda upp uppgraderingsfilen (.zip) som används med vihostupdate.

Lättast är att använda vihostupdate från vMA och kan göras med ett par enkla steg.

Förberedelse:

– En webbserver dit du kan lägga filer.

T.ex. apache eller IIS.

– vMA appliance

Kör appliance .ovf filen för vMA (från länken ovan) och kör igång på din ESXi server, alternativt klientmjukvarupaketet för ditt operativsystem.

– Uppgraderingsfilen (.zip)

Gå till www.vmware.com , logga in till ditt konto och gå till ESXi portalen (beroende på din license-nivå). För fria ESXi gå till ”Evaluation and Free products – VMWare ESXi”.

Ladda ned rätt upgrade zip , t.ex. ”ESXi 4.1 (upgrade ZIP from ESXi 4.0)” för VMWare ESXi 4.0 . Välj en annan för andra versioner.

Lägg denna .zip fil på din webbserver som kan nås via http.

Enkla uppgraderingssteg:

1. Migrera bort eller stäng ned dina virtuella maskiner på den ESXi host som ska uppgraderas.

2. Sätt din ESXi host i ”maintenance mode”.

3. Har du SSH access till ditt ESX/ESXi system kan du använda metod B annars använd metod A.

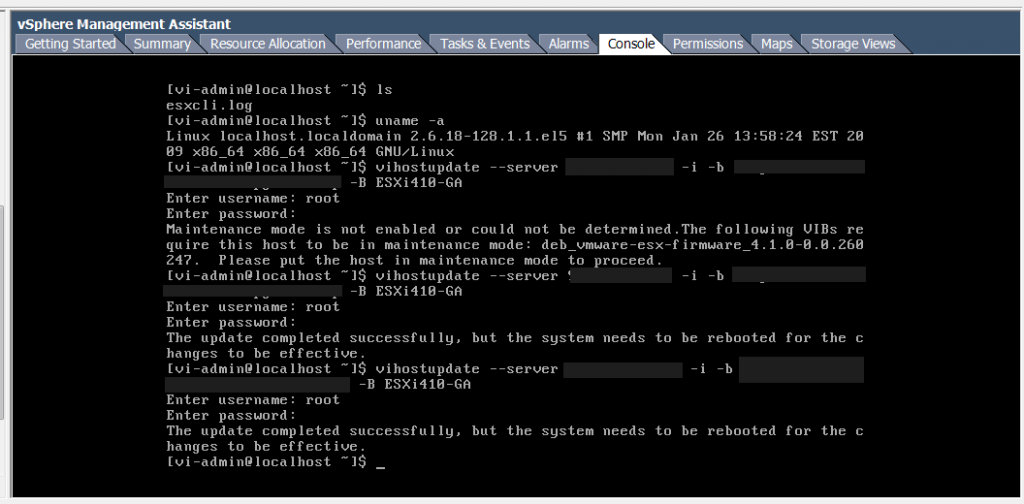

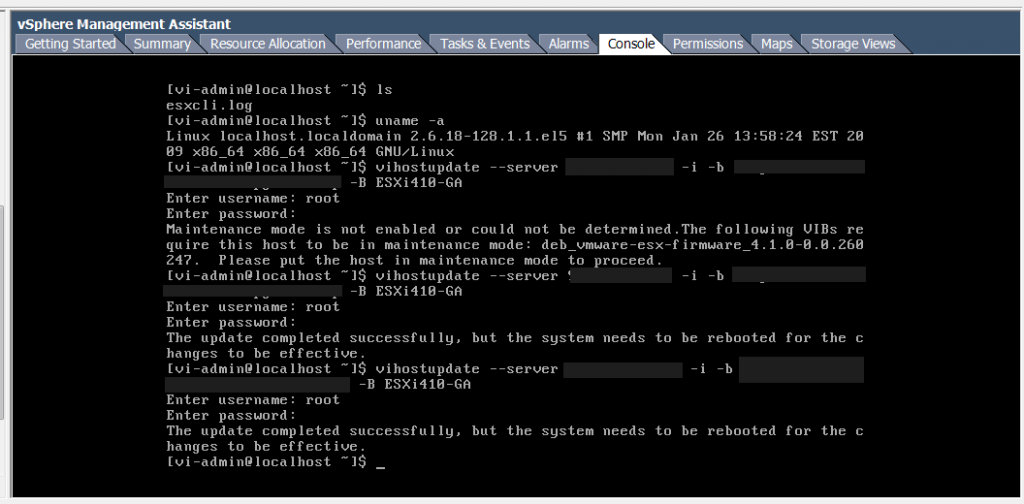

Metod A: Gå in i vMA appliance konsolen eller en kommandopromt om du laddat ned vmware console verktygen.

Skriv ”vihostupdate –server ”ip eller hostname till din esxi server” -i -b http://adresstilldinwebbserver/uppgraderingsfilensnamn.zip -B ESXi410-GA”

Kör du ESX istället för ESXi använder du ”ESXi410-GA-esxupdate” istället för bara ESXi410-GA ovan.

Metod B:

SSH:a till din ESXi/ESXi box och skriv i konsolen:

”esxupdate –bundle http://adresstilldinwebbserver/uppgraderingsfilensnamn.zip update”

Funkar allt ska din output vara:

”Enter username: din användare

Password:

The update completed successfully, but the system need to be rebooted for the changes to be effective.”

4. Starta om ditt ESX/ESXi och gå ur mainteinance mode.

OBS! Om du kör vCenter ska den uppdateras före vSPhere client. vSphere client måste uppgraderas oavsett.

Klart!

Källa:

kb.vmware.com/kb/1022140 – VMware KB: Upgrading ESX 4.0 to ESX 4.1