Det snackas mycket om molnet och cloud hosting.

Vad är molnet?

Med molntjänster (även kallat cloud Computing) menar man möjligheten att köra serverbaserade applikationer eller program över Internet. Traditionellt så brukar man hantera applikationer inom ett företag eller en organisation genom att installera applikationen på en egen fysisk server. Dessutom så ansvarar man för drift och underhåll av både server samt applikation själva eller genom att överlåta på en extern IT-leverantör (outsourcing).

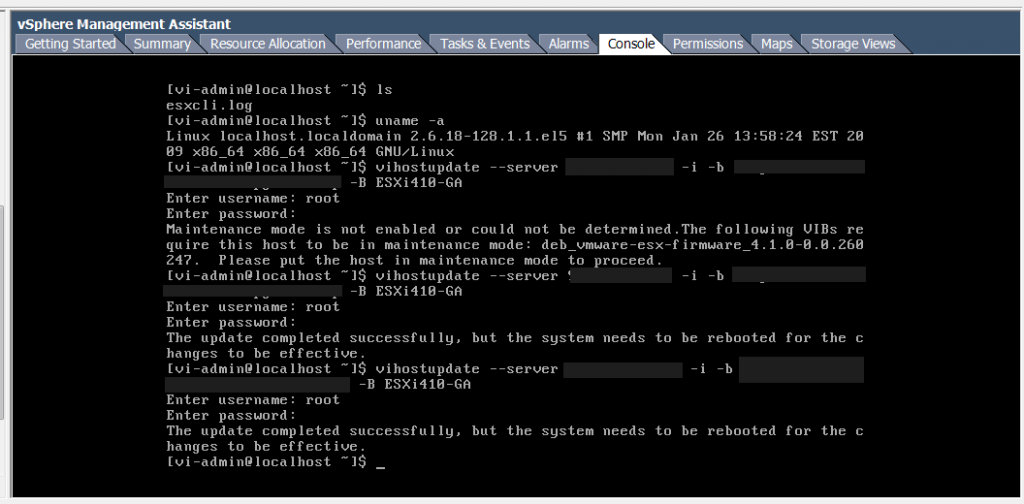

Inom molnet är det istället ofta tjänsteleverantörer som svarar för installation på sin server samt ansvarar för drift och underhåll av miljlön i egna datacenter. För att göra allt det här möjligt så brukar tjänsteleverantören använda virtualiserings-teknologi för att kunna dela upp resurserna bland olika applikationer och ”virtuella privata servrar”. På så vis kan man maximera resursutnyttjandet av de fysiska servrarna genom att tilldela precis så mycket resurser som behövs – till skillnad från det resursslöseri man riskerar att ha i en traditionell miljö.

Skillnad på moln och moln

Jag anser att olika leverantörer av molntjänster kan delas in i tre olika kategorier eller nivåer, så kallade tiers. Dessa nivåer är vad som spelar in på kvalité och pris av tjänsten. Ju högre nivå av tjänsten desto dyrare.

Den främsta skillnaden bland olika tiers är IOPs (operationer per sekund) kapacitet på deras lagringsplatform. Därefter kommer funktionaliteten.

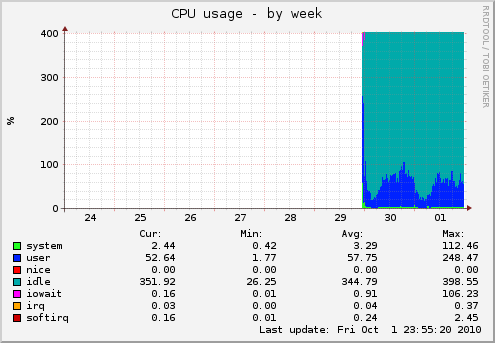

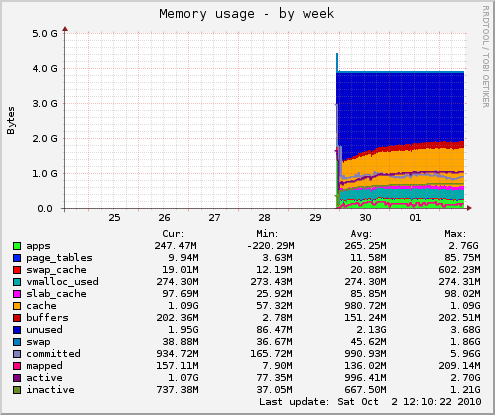

IO-prestandan är så pass viktig att om du har otur att välja en leverantör som har låg prestanda eller har sparat in på lagringsmiljön kan din virtuella privata server påverkas negativt av långsam läs- och skrivkapacitet. Priset på lagringsutrymme spelar roll på prestanda!

Har man inte högt ställda krav på IOPS prestanda och hellre vill ha maximalt lagringsutrymme så kanske man inte behöver välja de dyrare tiers. Har man dock krav på prestanda så får man nog satsa på de högre tiers.

Nedan har jag försökt klassifiera olika tiers och deras egenskaper:

– Premium tier

Högst driftsäkerhet, dedicerade infrastrukturresurser med flera niors upptid SLA. Deras lagringsmiljö är oftast bland de mest kvalificerade och högpresterande som kostat miljoner att driftsätta.

Oftast egen tekniskt platform som de själva driftar och utvecklar. De lever på sitt namn och har råd att ta betalt.

Dessa leverantörer brukar även leverera sin mjukvara till företag så att de kan hosta privata moln (virtuella miljöer). Ett exempel på dessa leverantörer är VMWare.

– Enterprise tier

Steget under Premium tier. De håller hög nivå på sin infrastruktur men är inte lika stora som premium tier. De har mindre datahallar och licensierar sin mjukvara från Premium tier leverantörer. De satsar även på att kunna leverera vad de lovar vilket driver upp priser någorlunda för lagringsutrymmen (SAN i hundratusenkronors klassen) men är inte lika dyra som Premium.

– Budget tier

Billigaste billiga. Vissa begränsningar i virtualiseringsfunktioner och överbokar gärna sina resurser för att hålla låga priser till slutkunder. De kör ofta mjukvarubaserade filsystem för att kunna maximera tillgängligt lagringsutrymme på bekostnad av IOPs prestanda. Distribuerade filsystem körs på vanliga konsument SATA diskar som har maximal lagringskapacitet, låg IOPs men även låga priser.

Hur kan man skilja på ett moln från ett annat då?

Priset!

Titta på grundpaketet från leverantören.

Kostar VPS:en man vill beställa bara mellan 50 och 120kr/må så kan man vara säker på att de sparat in på något. Är lagringsutrymme extremt billigt så kan man vara bombsäker på att det är distribuerade filsystem som använder långsamma SATA diskar för maximalt utrymme.

En start kostnad runt 170kr/mån brukar indikera Enterprise tier och allt ovanför 250kr/mån är Premium. Priserna för lagringsutrymme springer gärna iväg till många tior per GB diskutrymme.